Deuxième édition du FIASSF : Une approche collaborative à l’égard des menaces, possibilités et pratiques exemplaires liées à l’IA, Atelier 3 – L’intelligence artificielle et la stabilité financière

L’IA est une force de transformation à la fois impressionnante et potentiellement dangereuse. Son effet réel dépendra d’une innovation disciplinée et responsable ainsi que d’une solide collaboration sectorielle et internationale.

Préface

Le 29 octobre 2025, le Bureau du surintendant des institutions financières (BSIF), le ministère des Finances Canada (Fin), la Banque du Canada (BC) et le Global Risk Institute (GRI) ont organisé conjointement un atelier sur l’effet de l’intelligence artificielle (IA) sur la stabilité financière. Ce troisième atelier de la série de la deuxième édition du Forum sur l’intelligence artificielle dans le secteur des services financiers (FIASSF) réunissait plus de 50 experts canadiens et internationaux provenant du secteur financier, de la surveillance et de la réglementation fédéraux et provinciaux, des universités et des entreprises.

L’objectif de cet atelier était le suivant :

- Analyser comment l’adoption de l’IA amplifie les défis liés à la stabilité financière et déterminer des mesures appropriées d’atténuation des risques ainsi que des utilisations possibles de l’IA pour renforcer la robustesse du système financier.

Pour les besoins de cet atelier, la « stabilité financière » a été définieNote de bas de page 1 comme suit :

- Un système financier stable et résilient qui continue d’offrir des services essentiels pour soutenir l’économie en temps normal et pendant les périodes de crise. Un tel système est en mesure d’absorber les chocs plutôt que de les amplifier, ce qui réduit la nécessité d’une intervention officielle.

Les organisateurs ont sollicité le point de vue des participants sur i) les effets amplificateurs de l’IA sur les risques pour la stabilité financière, ii) les options d’atténuation possibles, iii) la détermination des utilisations de l’IA qui améliorent la stabilité et iv) les priorités qui devraient être désignées comme les « prochaines étapes ».

La première édition du FIASSF a vu le jour en 2022 en raison du besoin urgent de collaboration et d’élaboration de pratiques exemplaires pour favoriser l’adoption responsable de l’IA dans le secteur financier. Quatre ateliers ont été organisés, lesquels ont donné lieu à un rapport intitulé « Une perspective canadienne sur l’intelligence artificielle responsable ».

La planification de la deuxième édition du FIASSF, intitulée Une approche collaborative à l’égard des menaces, possibilités et pratiques exemplaires liées à l’IA, a commencé au début de 2025. Tenu en mai 2025, le premier atelier a permis de cerner les possibilités, les risques et les menaces en matière de sécurité et de cybersécurité. Organisé en octobre, le deuxième atelier portait sur la lutte contre les crimes financiers liés à l’intelligence artificielle.

Un quatrième atelier sur les risques liés à l’IA pour la protection des consommateurs a eu lieu le 13 novembre, et un rapport suivra. Un rapport final sur les réflexions et les conclusions de la deuxième édition du FIASSF sera également publié en mars 2026.

L’adoption de l’IA est à la fois une source de possibilités et de risques pour le secteur financier. Les organisateurs remercient sincèrement tous les participants à l’atelier et les conférenciers pour leur participation à ce dialogue collaboratif.

Global Risk Institute

Bureau du surintendant des institutions financières

Ministère des Finances Canada

Banque du Canada

Adoption de l’IA et stabilité financière

La plupart des participants à l’atelier ont convenu que, sans mesures d’atténuation appropriées, l’IA pourrait accroître les risques pour la stabilité financière.

Ils ont identifié trois voies par lesquelles les risques liés à l’IA pourraient se matérialiser. La première découle de l’adoption interne de l’IA par les institutions financières réglementées. La deuxième survient lorsque d’autres acteurs déploient une technologie d’IA qui a une incidence sur le système financier réglementé. Le troisième est en lien avec la vulnérabilité systémique des infrastructures partagées dont dépendent les institutions financières.

Les participants ont souligné que l’adoption de l’IA à plus grande échelle changera la façon dont les institutions financières et les marchés fonctionnent, ce qui aura des répercussions sur la gestion des risques institutionnels et systémiques. Pour atténuer le potentiel de l’IA à amplifier les risques pour la stabilité financière, il faudra mettre l’accent sur une gouvernance solide, des contrôles rigoureux des processus, une culture de sensibilisation approfondie aux risques et une compréhension des dynamiques à l’échelle du système.

Les participants ont cerné des domaines clés que devraient aborder le secteur, le gouvernement et les organismes de réglementation pour réduire au minimum les effets négatifs potentiels de l’IA sur la stabilité financière du Canada.

Cinq domaines dans lesquels l’IA pourrait amplifier le risque systémique

1. Défis liés à l’IA pour la résilience opérationnelle systémique

La capacité de détecter les chocs opérationnels, d’y réagir, de s’en remettre et de s’y adapter est essentielle à toute institution financière. La croissance rapide des services et des applications dépendants de l’IA augmente les enjeux non seulement pour les institutions individuelles, mais aussi pour le système dans son ensemble.

Selon les participants à l’atelier, la dépendance générale croissante à l’égard de tiers essentiels pour les services d’IA ainsi que les dépendances en aval des « nièmes parties » de la chaîne d’approvisionnement en IA amplifient le risque pour la stabilité financière. Il en va de même pour les fournisseurs d’infrastructures essentielles, comme les plateformes de paiement, qui peuvent également utiliser des outils d’IA, ce qui pourrait ouvrir la porte à des vulnérabilités susceptibles d’avoir une incidence sur le système.

La concentration de tiers fournisseurs de services d’IA constitue une menace importante pour la résilience opérationnelle. Au Canada, le secteur financier dépend d’un ensemble concentré de fournisseurs d’IA, y compris des développeurs de grands modèles de langage (GML), des services infonuagiques et des chaînes d’approvisionnement en matériel. Les risques de concentration sont aggravés lorsque les GML sont entraînés au moyen d’ensembles de données similaires ou ingèrent des données comparables une fois que ces modèles sont déployés, ce qui augmente la probabilité de défaillances corrélées et d’amplification à l’échelle du système. Cette dépendance à l’égard d’un petit nombre de fournisseurs mondiaux de services d’IA et d’infonuagique augmente le risque d’un point de défaillance unique qui pourrait devenir systémique.

De plus, la plupart de ces fournisseurs de services exercent leurs activités en dehors de la portée de la réglementationNote de bas de page 2, ce qui se traduit par une visibilité limitée de la probabilité d’une défaillance, et des répercussions potentielles que celle-ci pourrait avoir dans l’ensemble du système. Cela crée également un défi pour les institutions qui doivent assumer la responsabilité de la gestion des risques et de la conformité réglementaire pour les services qu’elles sous-traitent à l’externe.

Compte tenu du nombre limité de fournisseurs et des contraintes liées à la dépendance envers les fournisseurs, la résolution de ce risque n’est pas aussi simple que d’imposer des exigences de diversification des fournisseurs d’IA. Les participants ont généralement convenu que le choix des fournisseurs devrait être axé sur le marché et aligné sur les objectifs stratégiques d’une entreprise. Cela crée un point de départ difficile pour l’atténuation des risques.

Options d’atténuation recommandées

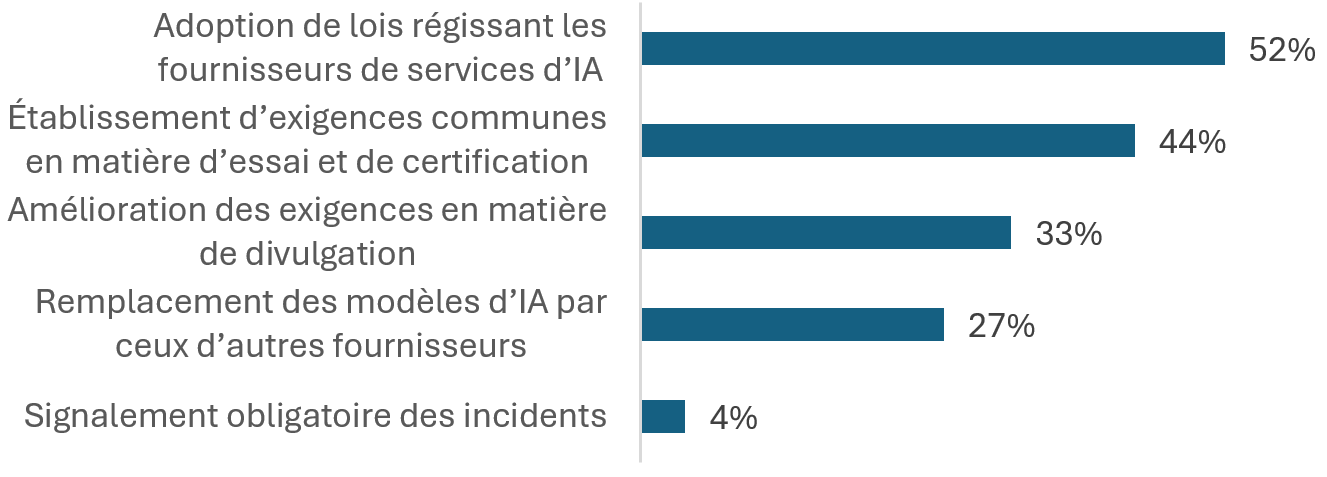

À la question « Quelle mesure renforcerait le plus la résilience face au risque lié aux tiers? », 52 % des participants à l’atelier ont indiqué qu’ils étaient en faveur de nouvelles lois visant à réglementer les fournisseurs de services d’IA tiers.

Les chiffres dépassent 100 parce que les participants pouvaient choisir 2 options.

Figure 1 - Version textuelle

| Adoption de lois régissant les fournisseurs de services d’IA | 52 % |

|---|---|

| Établissement d’exigences communes en matière d’essai et de certification | 44 % |

| Amélioration des exigences en matière de divulgation | 33 % |

| Remplacement des modèles d’IA par ceux d’autres fournisseurs | 27 % |

| Signalement obligatoire des incidents | 4 % |

Les participants ont souligné trois initiatives visant à atténuer les défis liés à la résilience opérationnelle qui amplifient le risque pour la stabilité financière :

- Assurer l’efficacité des mesures d’urgence liées aux tiers et de solides cadres de reprise des activités. Il s’agit notamment de tester rigoureusement ces mesures dans le cadre d’un éventail de scénarios graves, mais vraisemblables.

- Veiller à ce que les plans opérationnels d’intervention en cas de crise intègrent une collaboration suffisante entre les organismes de réglementation avec des rôles, des responsabilités et un pouvoir décisionnel interorganismes clairement définis.

- Établir des contrôles de gouvernance et une surveillance accrus pour chaque institution et à un niveau systémique. Pour ce faire, il faudrait déterminer quelles dépendances envers des tiers sont essentielles au système et mettre en place des mécanismes permettant une coordination et une communication rapides en cas d’incidents ayant des conséquences sur le système.

2. Augmentation de la volatilité des marchés attribuable à l’IA

La volatilité accrue pendant les périodes de crise peut être amplifiée par des décisions de marché synchronisées fondées sur des modèles d’IA entraînés au moyen de données similaires. Ces dynamiques pourraient contribuer à la perte de confiance, à la panique des marchés et à la réduction des liquidités au moment où l’on en a le plus besoin.

La volatilité des marchés attribuable à l’IA était considérée comme un risque d’importance systémique. Les algorithmes ou les modèles de négociation basés sur l’IA peuvent intensifier la volatilité des marchés, en particulier les fluctuations de prix à court terme. Les participants étaient d’avis que les marchés boursiers et les instruments dérivés négociés en bourse pourraient être particulièrement vulnérables aux perturbations attribuables à l’IA et aux changements procycliques en période de crise. En outre, les acteurs des marchés non réglementés, y compris les nouvelles entités, pourraient utiliser à grande échelle des outils d’IA complexes plus rapidement que les institutions financières réglementées. Il se peut que ces entités ne disposent pas de cadres de gestion des risques solides et de pratiques responsables en matière d’IA, ce qui pourrait accroître les risques sur les marchés financiers et la concentration des risques.

Il convient toutefois de noter que certains participants croient que la volatilité est un élément fondamental de leurs modèles d’affaires. Ils ont noté que les contrôles existants et les seuils techniques réduisent la probabilité d’un mimétisme systémique. Les institutions financières canadiennes ont également élaboré des stratégies et des modèles de négociation exclusifs basés sur l’IA qui ne dépendent pas de tiers, ce qui devrait contribuer à atténuer le mimétisme et d’autres comportements corrélés.

Options d’atténuation recommandées

Cinq initiatives ont été mises en évidence pour réduire l’amplification potentielle de la volatilité des marchés liée à l’IA :

- Mettre en œuvre des systèmes d’alerte précoce pour détecter les changements émergents dans la dynamique des marchés, tels que les changements dans la valeur, la vitesse et le volume des transactions.

- S’assurer que les dispositions coupe-circuit ont des seuils clairs permettant de réagir à une volatilité extrême.

- Promouvoir le développement et l’utilisation d’algorithmes de négociation entraînés à l’interne avec des approches exclusives plutôt que de s’appuyer uniquement sur des modèles et des données externes.

- Mettre en place de solides processus de gouvernance du risque qui comprennent des contrôles pour l’élaboration de modèles de négociation et pour la prévention de résultats indésirables en matière de négociation avec des normes d’intervention humaine pour les décisions dont le risque est élevé.

- Explorer la possibilité d’élargir les limites réglementaires pour couvrir les participants des marchés non réglementés lorsque leur utilisation de l’IA pourrait amplifier les risques systémiques.

3. Risques liés à l’IA agentique

Les risques découlant de modèles d’IA de plus en plus complexes et autonomes ont été abordés parce qu’on estime qu’ils constituent une menace possible pour la stabilité financière. Les participants ont notamment discuté du développement de l’IA agentique par les institutions financières et de l’incidence des systèmes d’IA agentique mis au point par des entreprises technologiques qui prennent des mesures financières. L’IA agentique se distingue des autres systèmes d’IA par sa capacité croissante à poursuivre des objectifs de manière autonome grâce à la prise de décision, à l’utilisation d’outils et à l’exécution de tâches en plusieurs étapes.

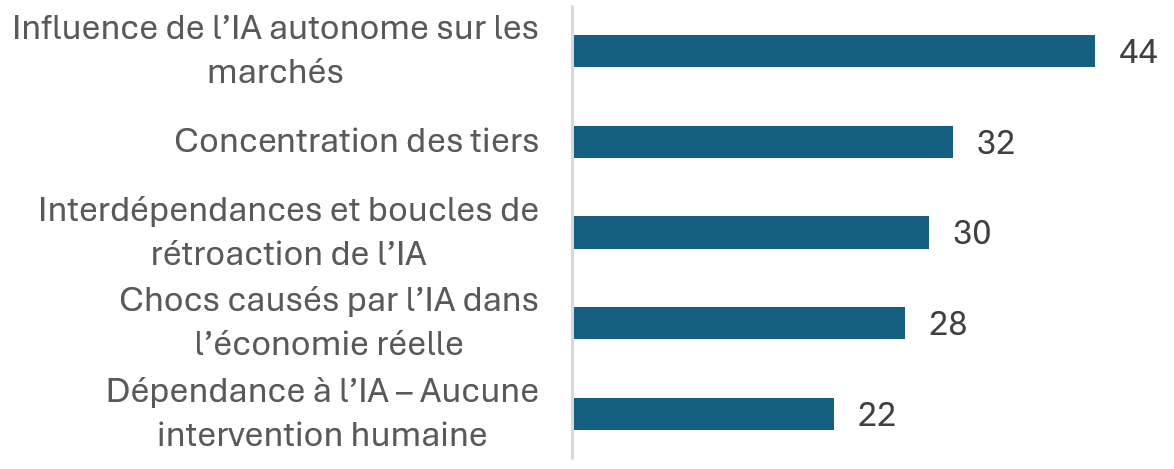

Les participants ont indiqué dans une proportion de 44 % que la principale source de risque systémique lié à l’IA aujourd’hui provient probablement des systèmes d’IA autonomes.

Les chiffres dépassent 100 parce que les participants pouvaient choisir 2 options.

Figure 2 - Version textuelle

| Influence de l’IA autonome sur les marchés | 44 % |

|---|---|

| Concentration des tiers | 32 % |

| Interdépendances et boucles de rétroaction de l’IA | 30 % |

| Chocs causés par l’IA dans l’économie réelle | 28 % |

| Dépendance à l’IA – Aucune intervention humaine | 22 % |

Le comportement autonome des systèmes d’IA agentique peut entraîner des résultats imprévus, ce qui soulève des préoccupations allant du biais décisionnel à la manipulation des marchés. Ces capacités d’intervention rapide et cette autonomie peuvent faire de la surveillance un défi. La capacité de l’IA agentique à exécuter des transactions importantes sans intervention humaine est considérée comme un facteur potentiel de problèmes systémiques.

Les participants à l’atelier ont dit craindre que les mesures de protection ne soient pas suffisantes pour permettre de surveiller et de contrôler les capacités des agents d’IA. Ils ont comparé les risques de l’IA agentique à ceux associés à un spéculateur malhonnête et ont suggéré que ce type d’IA devrait déclencher des mesures similaires de gestion des risques. Un conférencier principal a fait remarquer que les systèmes d’IA peuvent exploiter des failles dans la façon dont les objectifs sont définis, ce qui leur permet d’éviter les contrôles, les limites et les mesures de protection. Selon lui, compter sur les règlements en vigueur en ce qui concerne l’intention n’est pas une approche responsable pour gérer ce risque.

Les données et la qualité des données sont essentielles pour minimiser les risques liés au déploiement de l’IA. L’atténuation des risques est entravée si les institutions n’accordent pas une priorité suffisante à la qualité des données utilisées pour entraîner les modèles d’IA. En général, les données peuvent être mal organisées, difficiles d’accès ou de qualité insuffisante. Ce risque est plus élevé dans les systèmes agentiques, pour lesquels il peut être difficile d’obtenir des données d’entraînement fiables et suffisamment diversifiées. En l’absence de mesures de surveillance et de suivi technologiques, le risque de manipulation ou de contamination par les auteurs de menaces augmente. À mesure que les agents d’IA accèdent de plus en plus aux outils et aux systèmes internes, l’ampleur et la portée du risque sont amplifiées.

Bien que tous les modèles d’IA générative soient soumis à des risques d’hallucination, les erreurs s’accumulent dans les systèmes agentiques, en particulier lorsque plusieurs agents collaborent sur un flux de travail en plusieurs étapes. L’entraînement des agents s’ajoute au manque de transparence et d’explicabilité déjà présent dans les modèles d’IA de base. De plus, le diagnostic est difficile, parce qu’il est pratiquement impossible de reproduire les voies décisionnelles.

Les agents d’IA mis au point par des entités externes, comme des entreprises de technologie, pourraient également présenter des risques. Par exemple, les investisseurs individuels pourraient bénéficier d’un accès à des outils de négociation d’IA agentique parce que ceux-ci pourraient réduire les obstacles à une participation plus sophistiquée et active sur les marchés. Cependant, les investisseurs individuels qui s’appuient sur de tels outils peuvent également contribuer par inadvertance à une volatilité et à un risque accrus. Un autre exemple d’utilisation risquée de l’IA agentique est celui des activités de trésorerie des entreprises. Ces agents d’IA peuvent réduire la stabilité des dépôts des entreprises sur les bilans des intermédiaires financiers s’ils réagissent plus activement aux nouvelles, aux rumeurs sur les réseaux sociaux ou aux taux affichés des marchés.

Options d’atténuation recommandées

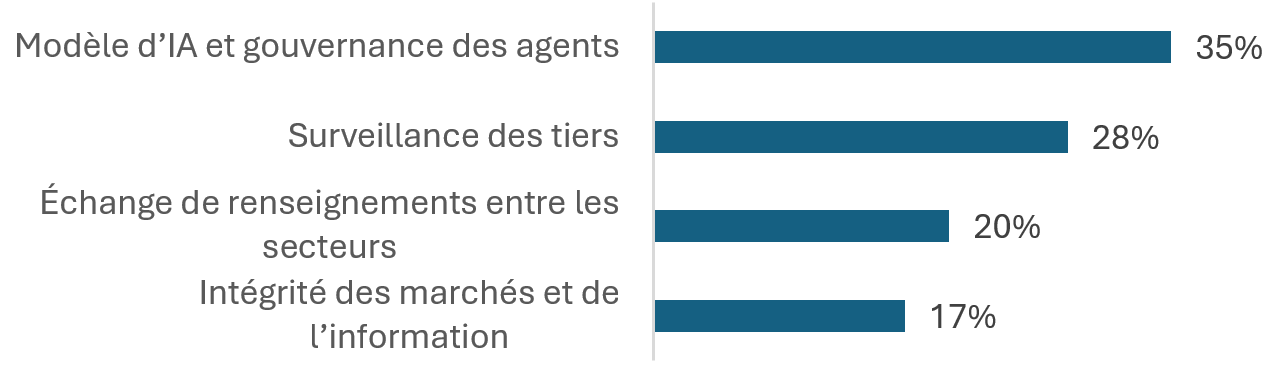

Lorsqu’on leur a demandé quelles étaient leurs mesures d’atténuation préférées pour la coordination et la surveillance des politiques afin de préserver la stabilité financière, 35 % des participants ont choisi le modèle d’IA et la gouvernance des agents.

Les chiffres dépassent 100 parce que les participants pouvaient choisir 2 options.

Figure 3 - Version textuelle

| Modèle d’IA et gouvernance des agents | 35 % |

|---|---|

| Surveillance des tiers | 28 % |

| Échange de renseignements entre les secteurs | 20 % |

| Intégrité des marchés et de l’information | 17 % |

Les stratégies suivantes ont été définies pour atténuer les risques pour la stabilité financière découlant de l’IA agentique :

- Adopter une surveillance et des contrôles continus alimentés par l’IA pour l’IA agentique afin de réduire les sphères d’action et d’éviter la dépendance excessive. Par exemple, s’assurer que les agents ont des identités numériques distinctes, et que lorsqu’un agent en supervise un autre, les modèles sous-jacents sont différents.

- Encourager la littératie en matière d’IA et la formation axée sur les rôles avant le déploiement de systèmes d’IA agentiques.

- Établir des lignes directrices claires en matière de contrôle concernant les décisions qui nécessitent une approbation humaine (intervention humaine) et toutes les fonctions pour lesquelles des agents d’IA autonomes ne devraient pas être déployés.

- Combler les lacunes en matière de transparence et améliorer la responsabilisation; la chaîne de blocs pourrait être un moyen d’y parvenir.

4. Perturbations du marché du travail et des secteurs d’activité liées à l’IA

Les participants ont convenu que l’adoption de l’IA à l’échelle de l’économie pourrait perturber considérablement le marché du travail et les entreprises dans les secteurs fortement touchés par cette technologie. Les perturbations économiques causées par l’IA pourraient accroître le risque de crédit pour les institutions financières en raison de leur exposition aux prêts consentis à des personnes et à des entreprises touchées négativement. L’ampleur, le moment et la durée de ces perturbations économiques détermineront l’étendue du problème.

Selon certains participants, les interruptions de travail et l’augmentation connexe du risque de crédit constituent le principal moteur des chocs systémiques potentiellement importants liés à l’IA. Une dépendance excessive à l’égard des outils d’IA pourrait exacerber toute inadéquation des compétences sur le marché du travail, ce qui entraînerait une perte de compétences du personnel et une pénurie de talents dans les rôles émergents. Dans un scénario où les pertes d’emploi s’accumulent, les institutions financières pourraient devoir rajuster leurs évaluations du risque de crédit et les facteurs de risque qu’elles utilisent.

Les participants ont laissé entendre que les conséquences pourraient mener à une économie en K, où certains secteurs voient des entreprises et des particuliers prospérer, tandis que d’autres font face à des occasions de moins en moins nombreuses. On a fait remarquer que cette dynamique est généralement défavorable aux prêteurs, car les avantages attribuables à leur exposition à des particuliers et à des entreprises qui prospèrent sont limités, tandis que leur exposition aux prêts consentis à des personnes et à des entreprises touchées négativement pourrait être importante.

Options d’atténuation recommandées

Voici les pratiques exemplaires identifiées pour atténuer la perte de confiance et les perturbations du marché du travail attribuables à l’IA :

- Améliorer les pratiques de simulation de crise pour tenir compte des scénarios où les effets d’une adoption de l’IA à plus grande échelle peuvent avoir des répercussions macroéconomiques importantes.

- Mettre l’accent sur l’éducation et la communication pour accroître les possibilités d’emploi et de perfectionnement.

- Améliorer le partage de données entre le secteur et le gouvernement afin d’établir un lien plus clair entre la perte d’emploi et le risque de crédit potentiel.

- Insister sur l’importance de surveiller et d’identifier les indicateurs d’alerte précoce, puis de prendre des mesures efficaces pour contrer les risques de crédit émergents.

- Envisager des mesures incitatives pour encourager les institutions financières à redéployer plutôt qu’à déplacer les employés actuels touchés par la perte d’emploi causée par l’IA.

5. Défis liés à l’adoption rapide et prudente de l’IA

De nombreuses institutions financières, ainsi que le gouvernement et les organismes de réglementation, doivent trouver un équilibre entre l’adoption rapide de l’IA et l’amélioration de la surveillance, de la gouvernance et de l’expertise interne en matière d’IA. L’innovation et l’adoption de l’IA sont essentielles à l’amélioration de la productivité et de la compétitivité du secteur financier canadien, et agir trop lentement, que ce soit en raison de décisions prudentes ou d’autres facteurs, pourrait être tout aussi nuisible que l’adoption trop rapide de l’IA sans une gestion adéquate des risques.

Selon les participants, l’innovation et l’adoption de l’IA sont essentielles à la réussite future du secteur financier canadien. Durant les ateliers, plusieurs participants ont déclaré que « le plus grand risque est de ne pas en faire assez », tout en insistant sur l’importance de trouver un juste équilibre entre la nécessité d’innover à un rythme rapide et le devoir de le faire de façon responsable.

Les institutions ont besoin de capitaux suffisants, d’une expertise en IA, de l’infrastructure appropriée et d’une gouvernance solide pour déployer l’IA de façon efficace et responsable. Les participants ont fait valoir que le manque d’engagement de la part des organisations pour ce qui est d’adopter l’IA de façon active et responsable pourrait poser des risques opérationnels et stratégiques importants susceptibles d’avoir des répercussions sur la stabilité financière. L’une des principales raisons qu’ont les institutions financières pour adopter l’IA est de lutter contre la croissance des risques externes liés à l’IA et découlant de la cybersécurité, de la fraude et d’autres secteurs (voir les rapports disponibles : Atelier 1 – Sécurité et cybersécurité et Atelier 2 – Criminalité financière). De plus, selon certains participants, ne pas adopter l’IA dans leur organisation pourrait représenter des risques stratégiques importants si les concurrents obtenaient un avantage important en tirant mieux parti de la technologie.

Les organismes de réglementation et le gouvernement doivent également adopter l’IA au rythme approprié pour assurer une surveillance efficace et la stabilité financière au Canada. Les organismes de réglementation financière s’efforcent de trouver un équilibre entre le soutien à l’innovation technologique responsable au sein des institutions financières et la conformité de ces efforts aux principes des lignes directrices existantes concernant la réglementation.

Certains participants du secteur financier ont exprimé des préoccupations au sujet de leur capacité à adopter rapidement des systèmes d’IA. Tout d’abord, il y a une pénurie de talents qualifiés en IA, aggravée par les défis liés à la littératie en IA et un manque perçu de formation interne et de perfectionnement dans l’ensemble de l’industrie. Ensuite, il existe une vive concurrence interne pour les budgets d’investissement et de recherche et développement au sein des institutions. Les participants se sont également demandé si le secteur avait la capacité d’harmoniser les compétences en IA en fonction du rythme d’adoption. Ils ont souligné la nécessité d’une souplesse réglementaire qui favorise une adoption responsable avec des contrôles appropriés.

Options d’atténuation recommandées

- Mettre l’accent sur les principes fondamentaux de la gouvernance et de la gestion des risques qui permettent d’aligner le déploiement de l’IA sur les contrôles appropriés.

- Promouvoir l’investissement dans les outils et les systèmes d’IA et leur adoption responsable, en particulier pour contrer les menaces accrues des acteurs malveillants qui utilisent cette technologie.

- Mettre l’accent sur l’éducation, la communication et le développement des compétences en matière d’IA au sein des institutions individuelles et dans l’ensemble du secteur.

- Veiller à ce que des équipes multidisciplinaires soutiennent le déploiement de l’IA afin de favoriser une harmonisation stratégique, de préciser la séparation des tâches et de réduire au minimum le risque de fragmentation.

Possibilités et priorités pour réduire le risque de stabilité financière

La question qui se pose à vous est la suivante : vos institutions ont-elles l’audace de créer de la valeur pour vos clients et vos actionnaires, ou vous cachez-vous derrière le gradualisme en attendant qu’un organisme de réglementation propose des innovations plutôt que d’exiger à votre organisme de réglementation qu’il en propose? [traduction libre]

Plusieurs occasions d’améliorer la résilience et la stabilité financière ont été soulignées :

- Élargir le pouvoir de réglementation du Canada à l’égard des tiers essentiels.

- Les participants ont fait valoir la nécessité d’élargir le régime de réglementation du Canada pour y inclure les fournisseurs tiers essentiels dans le but d’atténuer le risque de concentration. L’un des modèles recommandés était le Critical Third Parties Regime (régime de réglementation sur les tiers essentiels) de 2024 du Royaume-Uni, qui établit des normes de service et de résilience pour les tiers essentiels. Ce régime élargi comprendrait une surveillance accrue des infrastructures essentielles d’IA et de technologie, et désignerait possiblement des éléments du secteur financier ou des infrastructures d’IA comme « d’importance systémique » pour la surveillance gouvernementaleNote de bas de page 3.

- Améliorer la capacité d’intervention nationale en ce qui concerne les infrastructures financières essentielles.

- On a proposé un examen des fonctions nationales existantes pour intervenir en cas d’incident systémique touchant un tiers essentiel ou une autre infrastructure financière essentielle, compte tenu des risques élevés découlant de l’IA pour le secteur financier. Cet examen pourrait prendre la forme d’un groupe national de coordination de l’IA, d’un guide du plan de reprise après sinistre ou simplement d’un cadre propre au système financier. Une partie de cet effort pourrait consister à déterminer quels sont les fournisseurs de services essentiels au secteur financier et à surveiller les incidents.

- Tirer parti d’outils d’IA pour assurer la surveillance.

- L’un des domaines où les superviseurs pourraient déployer des outils d’IA est la schématisation et la surveillance en temps réel des incidents et de la dépendance envers des tiers en établissant des liens entre les institutions et les fournisseurs, ce qui permettrait d’accroître la visibilité et de déceler rapidement les vulnérabilités systémiques. L’IA pourrait également être utilisée pour surveiller les tendances du marché et identifier les incidents potentiels suscitant la volatilité ou touchant les liquidités. Un autre domaine pourrait être l’utilisation de l’IA par les systèmes agentiques, en particulier ceux déployés par des entités extérieures au système réglementé, pour surveiller la croissance des activités. Les systèmes de surveillance de l’IA pourraient aussi être utilisés pour surveiller les effets de l’IA sur le marché du travail et l’économie en général.

- Possibilités de créer un bac à sable de l’IA.

- Les institutions financières canadiennes se sont principalement penchées sur les cas d’utilisation de l’IA à faible risque pour accroître l’efficacité opérationnelle et améliorer les processus. Un environnement de bac à sable pourrait permettre de tester des outils d’IA avant de les déployer dans des systèmes orientés vers le marché ou dans d’autres domaines à risque élevé.

- Adopter un état d’esprit axé sur la croissance de l’IA.

- Bien que l’IA soit souvent conceptualisée comme un moyen de réduire les coûts et d’accroître l’efficacité, elle peut aussi représenter une occasion sans précédent de croissance et de compétitivité accrue. Les institutions financières peuvent adopter cet état d’esprit tant dans la façon dont elles élaborent leurs plans stratégiques que dans la façon dont elles gèrent les transitions de changement pour leur personnel. L’amélioration des services existants et l’offre de nouveaux services sont une façon optimale d’utiliser les ressources humaines et technologiques pour augmenter les revenus.

- Collaborer à l’échelle du secteur pour renforcer la stabilité financière.

- Les participants ont appelé à une collaboration accrue visant à réunir le secteur, les organismes de réglementation, les décideurs politiques, les entreprises technologiques et le milieu universitaire pour qu’ils puissent partager les dépendances à l’IA, promouvoir l’échange de renseignements, élaborer des systèmes de taxonomie et des mesures communes et établir des normes de certification par des tiers.

- Perfectionnement des compétences et de la littératie en IA.

- Il est toujours nécessaire de renforcer les compétences et la littératie en matière d’IA dans le secteur financier, son régime de surveillance et au Canada en général. Favoriser l’éducation et la formation pourrait contribuer à atténuer les perturbations du marché du travail. De plus, le renforcement des compétences en matière de gestion des risques et d’autres fonctions permettrait d’améliorer la surveillance.

Prochaines étapes

Le Forum qui se tient aujourd’hui nous offre une formidable occasion de mieux comprendre l’IA et son rôle dans le secteur financier et d’atténuer les risques que cette technologie représente pour la stabilité financière. Mieux comprendre ces points peut dissiper des craintes non fondées et ainsi permettre aux décideurs politiques de se concentrer sur les vrais problèmes. [traduction libre]

Les participants ont souligné que l’IA pourrait amplifier les risques pour la stabilité financière. Les discussions de l’atelier ont permis de clarifier la nature des risques, les mesures d’atténuation possibles et les possibilités pour le secteur d’aller de l’avant et de prospérer dans une ère de changements technologiques sans précédent.

Le défi immédiat du secteur financier est de trouver un équilibre entre le besoin essentiel d’innovation et d’adoption de l’IA et la gouvernance efficace de l’IA et la gestion des risques. La mise en place de garde-fous appropriés est essentielle pour assurer la stabilité, la croissance et l’innovation institutionnelles et systémiques. En outre, les institutions et les autorités prudentielles doivent surveiller avec vigilance les signes d’effets systémiques importants attribuables à l’IA.

Un rapport final qui sera publié en mars 2026 résumera les points de vue des quatre ateliers sur les risques, les menaces et les possibilités découlant de l’adoption de l’IA dans le secteur financier.